고정 헤더 영역

상세 컨텐츠

본문 제목

[논문 리뷰 스터디] What uncertainties do we need in Bayesian deep learning for computer vision? [NeurlPS 2017]

본문

작성자: 15기 이승은

1. Introduction

머신러닝/딥러닝 모델의 “불확실성”에 관하여

내가 만든 모델이 “모른다”라고 말할 수 있어야 한다

그리고 “모른다”라고 말할 수 있는 기준이 “불확실성”

e.g.) 강아지와 고양이를 분류하는 모델

→ 앵무새 사진이 들어왔을 때 “모른다”라고 말할 수 있어야지, 강아지나 고양이 둘 중 하나로 분류하면 안된다

- 이러한 불확실성에도 종류가 있다.

1) Epistemic Uncertainty (modEl)

모델로부터 나오는 불확실성

모델링을 하는 과정에서 이 모델이 내린 결정이 얼마나 불확실한지를 나타내는 지표

2) Aleatoric Uncertainty (dAta)

데이터로부터 나오는 불확실성 (데이터를 수집하는 과정에서 발생한 불확실성)

2-1) Homoscdastic Aleatoric Uncertainty

데이터 수집 과정에서 sample마다 동일한 불확실성이 발생하여 수집되는 것

카메라 렌즈에 먼지가 하나 붙어있음 → 이 사진기로 사진을 찍으면 모든 사진에 동일한 먼지(error)가 불확실성이 됨

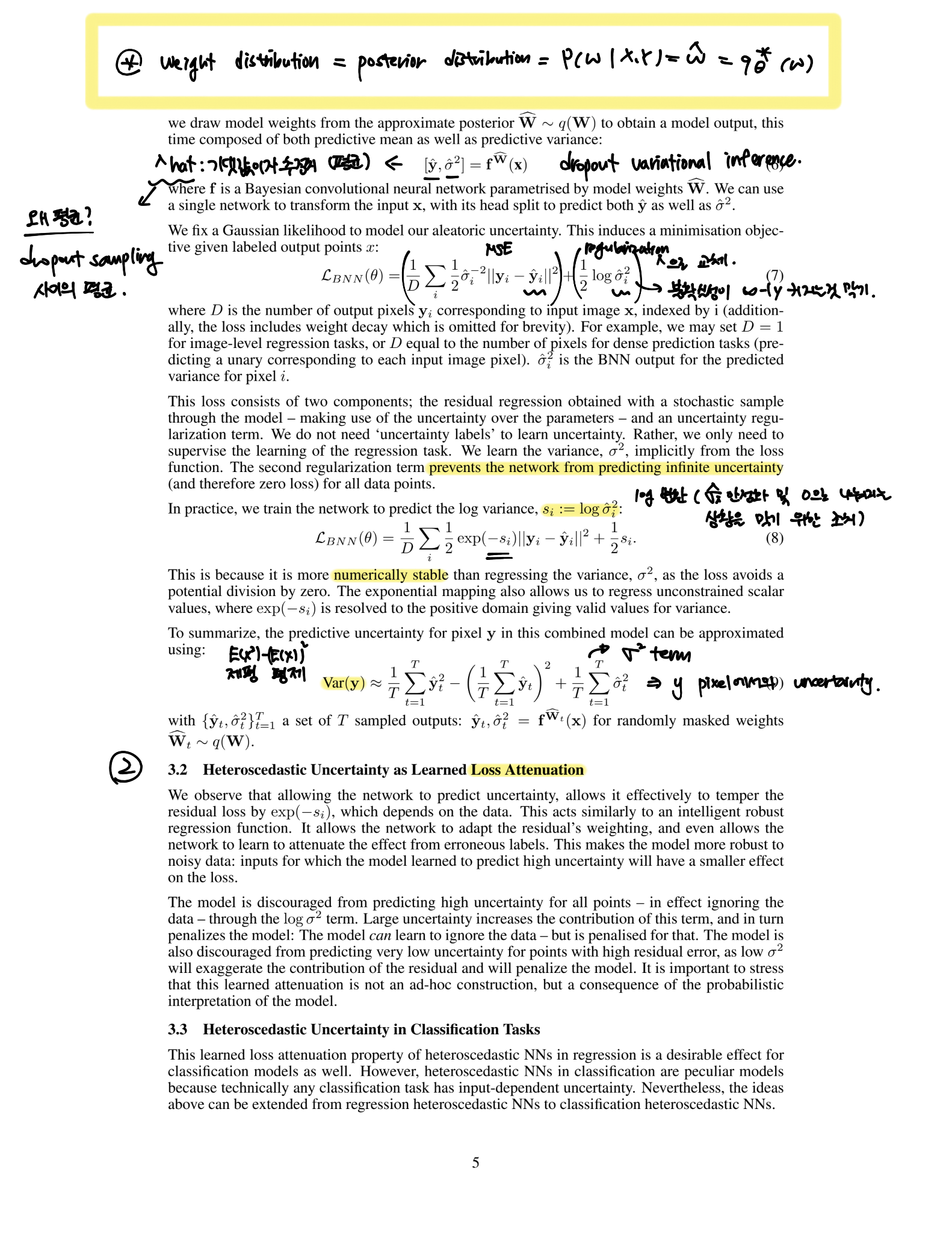

2-2) Heteroscedastic Aleatoric Unertainty

데이터 수집 과정에서 sample마다 서로 다른 불확실성이 발생하여 수집되는 것

- 이 논문의 시사점

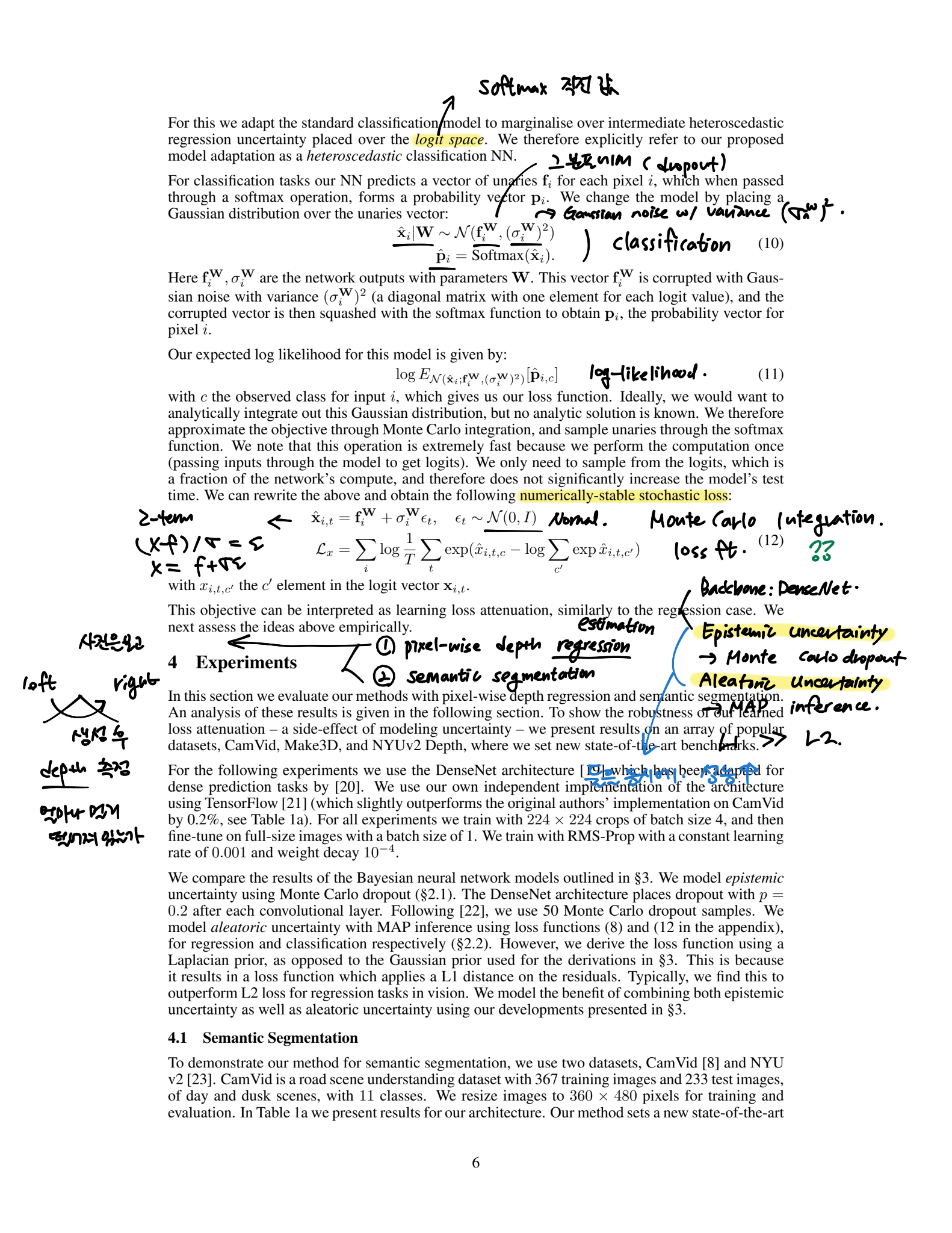

1) Aleatoric Uncertainty와 Epistemic Uncertainty 두 불확실성을 한 번에 측정

- 기존의 연구: 하나의 불확실성만 측정 가능 -> 전체의 불확실성으로 나타낼 수 있음을 보임

2) 베이지안이 아닌 모델보다 1-3% 정도 성능 향상

3) Aleatoric Uncertainty와 Epistemic Uncertainty 사이의 trade-off에 관한 연구

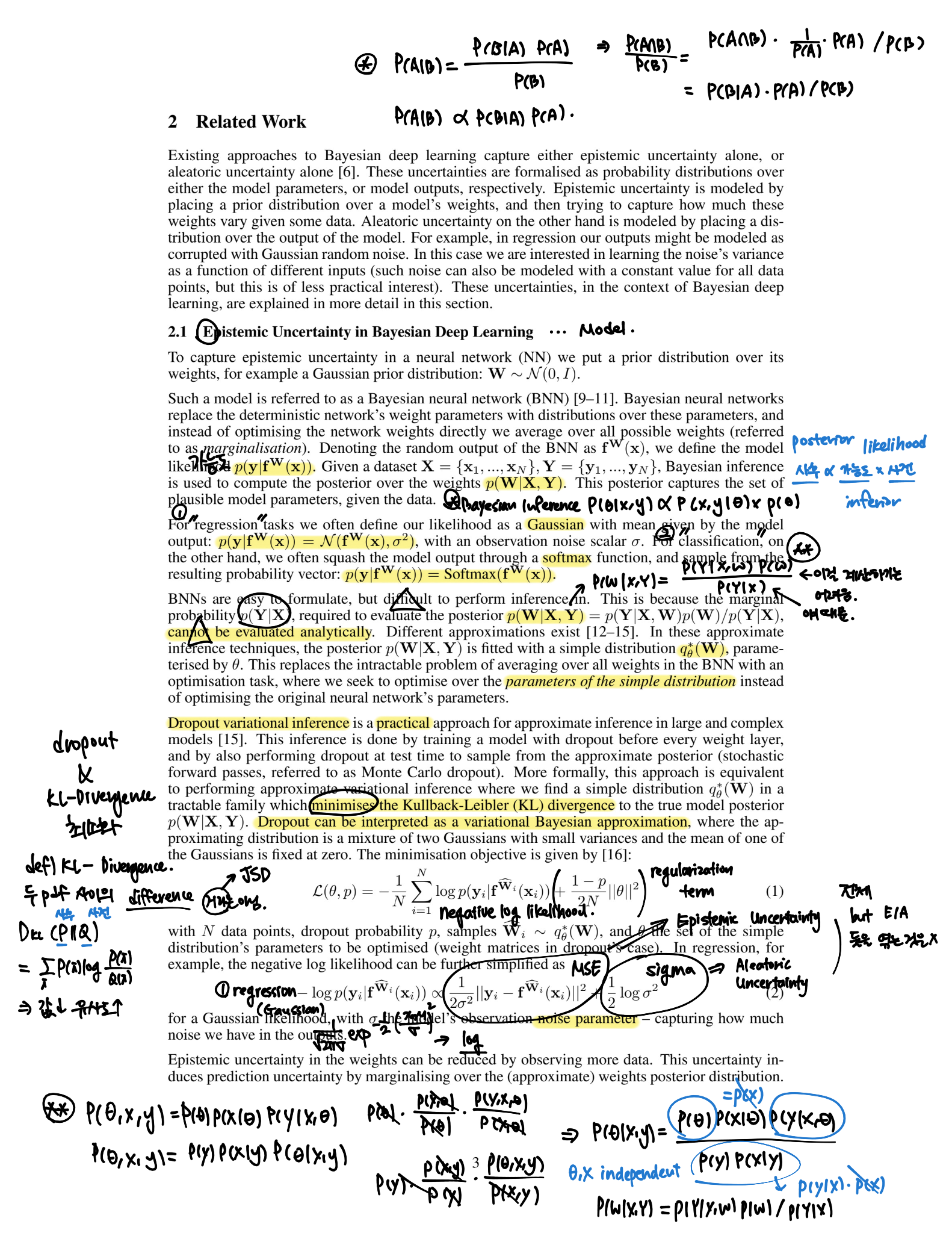

2. Related Work

Deterministic vs. Bayesian

1) Deterministic Models (기존 Neural Network)

weight as a set of fixed constants (updated w/ gradient descent)

2) Bayesian Models

drop out 느낌 → drop out은 각 노드들이 p의 확률로 포함 / 미포함 결정

→ p에 따라 다양한 “weight의 분포”가 만들어짐

→ 이렇게 하면서 실제 분포에 근사시키는 과정: Monte Carlo 근사

ref.

https://arxiv.org/abs/1703.04977

https://signing.tistory.com/61

댓글 영역