고정 헤더 영역

상세 컨텐츠

본문 제목

[Advanced ML & DL Week5] USAD : UnSupervised Anomaly Detection on Multivariate TimeSeries

본문

작성자: 15기 이병주

기존 모델

LSTM-AE (Unsupervised)

MAD-GAN (Unsupervised)

Introduction

AE based, GAN based는 한계점이 있다.

AE based: 정상 데이터를 잘 복원하도록 학습되기 때문에 정상과 아주 비슷한 이상치를 잘 탐지하지 못함

GAN based: 학습이 불안정해서 mode collapse, non-convergence 문제 발생

AE에 adversarial training을 접목하여 한계점을 해결

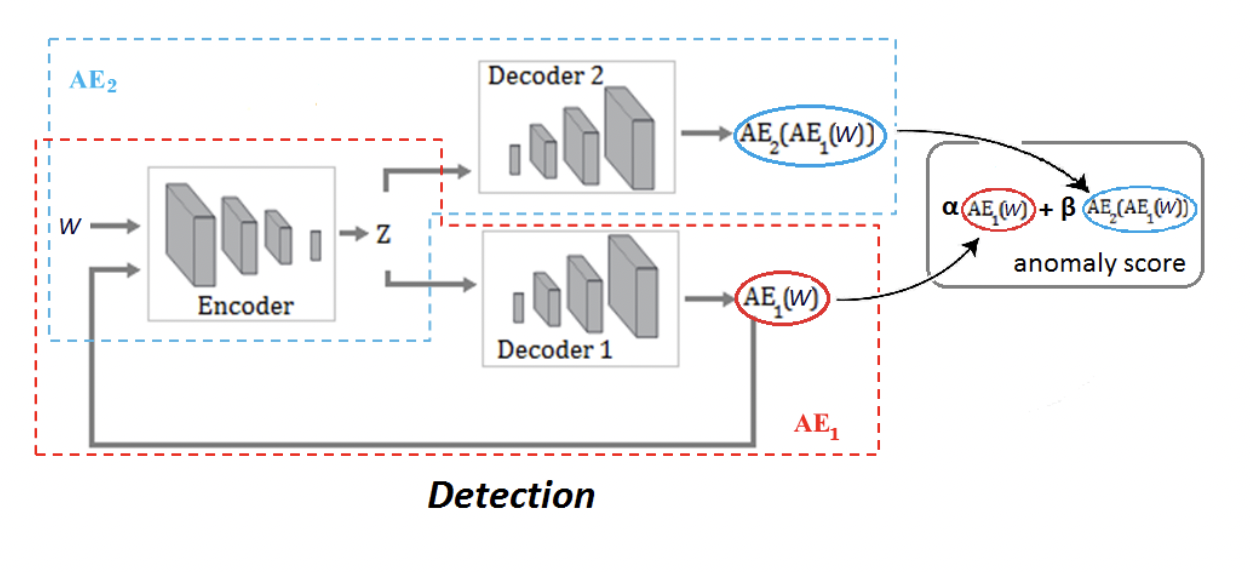

UnSupervised Anomaly Detection (USAD) method

3가지 element로 이루어짐

encoder network E

두개의 decoder network D1, D2

Phase 1: Autoencoder Training

하나의 encoder 사용

동일한 구조의decoder 2개 사용해서 encoder 공유하는 두개의 AE 구축

Phase 2: Adversarial Training

AE1: minimize reconstruction error of W(phase 1),

minimize the difference between W an the reconstructed output of AE2 (phase 2)

--> AE2를 잘 속일 수 있도록 복원 잘해야함

AE2: minimize reconstruction error of W(phase 1),

maximize the reconstruction error of the input data reconstructed by AE1 (phase 2).

--> AE1이 복원한 것을 잘 구분해야함

쉽게 말해서 AE1 은 generator 역할, AE2는 discriminator 역할

앞부분이 phase 1, 뒷부분이 phase 2

n= epoch

초기에는 reconstruction에 가중치를 주고 후반에는 adversarial training에 가중치 부여

Anomaly score (GAN based와 유사하게 score 산출)

𝚊 + β =1

𝚊 > β 인 경우 : TP, FP 감소, sensitivity가 작음

𝚊 < β 인 경우 : TP, FP 증가, 노이즈가 아주 작은 데이터도 이상치로 탐지함

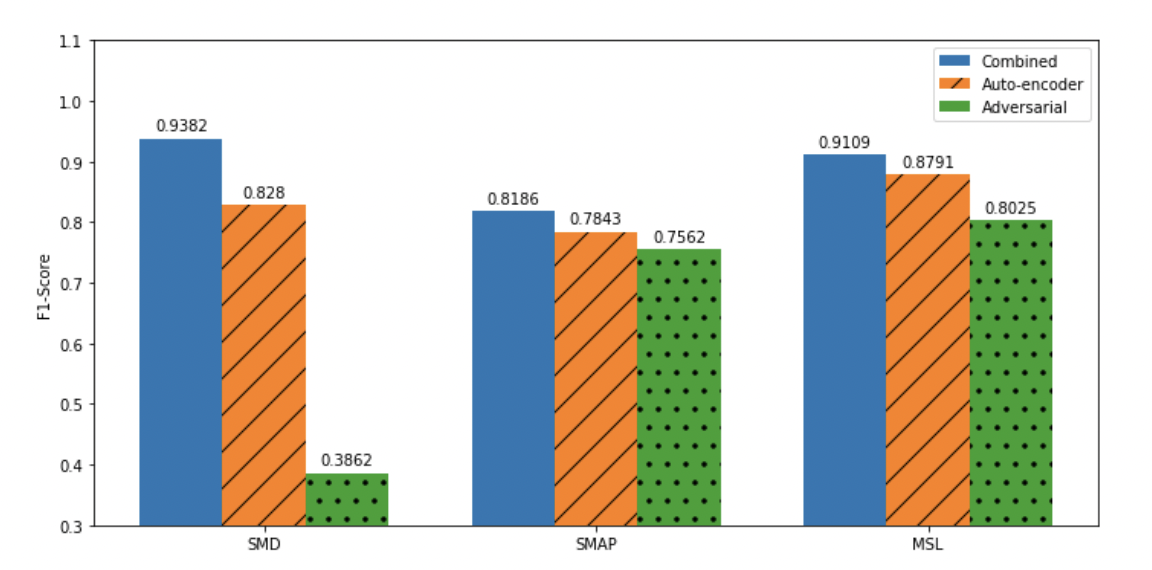

Experiment

baseline

IF(Isolation Forest) , DAGMM(Deep autoencoding Gaussian mixture model): 시간정보를 반영하지 못함

AE, LSTM-VAE, OmniAnomaly : 시간정보 반영 가능

알파 베타에 민감하기 때문에 상황에 따라 적절하게 설정해줘야함

2 phase의 효과를 보여줌

'심화 스터디 > Advanced ML & DL paper review' 카테고리의 다른 글

| [Advanced ML & DL Week6] GAN 모델 구현 및 DCGAN (0) | 2022.11.24 |

|---|---|

| [Advanced ML & DL Week 5] Long Short-Term Memory (0) | 2022.11.11 |

| [Advanced ML & DL Week5] Layer Normalization (0) | 2022.11.10 |

| [Advanced ML & DL Week5] word2vec: Efficient Estimation of Word Representations in Vector Space (0) | 2022.11.10 |

| [Advanced ML & DL Week5] Generative Adversarial Nets (0) | 2022.11.10 |

댓글 영역